最好多多推荐一些对中国本土的一些互联网用词——比如说“卧槽,给力,牛逼,好六,六六六,水贴,爆吧,女票,男票,蓝孩子,孩纸”之类的俚语也能有很好的分词能力的中文分词API就好了。

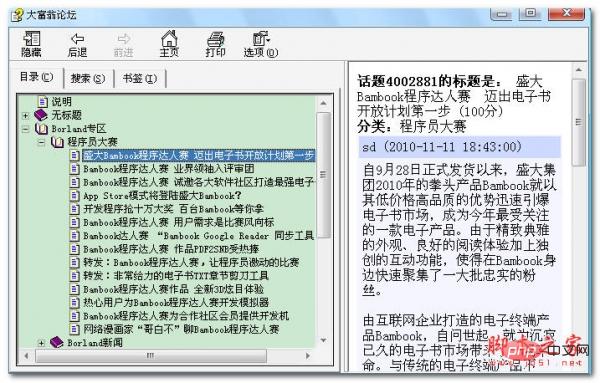

一个专门讨论Delphi的技术论坛,上面高手如云,是国内人气最盛、质量最高的Delphi讨论站。本文件根据该论坛的离线数据包生成,支持全文检索,话题ID检索,并实现了自动换行。由于某些话题正文中的HTML Tag会干扰CHM的生成,所有正文的HTML Tag 已全部转成明文。其中2006年的话题ID:3331380,3538052,3562469,3349720,3357640,3384303由于行数太多, 会使HTML Help Workshop产生非法操作错误,已在生成时删除了n行。

回复内容:

稍微体验过的,简单收录下- 哈工大:语言云(语言技术平台云 LTP-Cloud)

- 东北大学NiuTrans统计机器翻译系统:东北大学自然语言处理实验室

- 中科院张华平博士ICTCLAS :NLPIR汉语分词系统

- 波森科技:首页 - BosonNLP

- 结巴:fxsjy/jieba · GitHub

- Ansj分词:中国自然语言开源组织

http://bosonnlp.com/

总的来说很准确,当然也不是任何时候都管用...... 233333333

结巴分词。项目地址:fxsjy/jieba · GitHub

结巴分词。项目地址:fxsjy/jieba · GitHub>>>seg_list = jieba.cut("他来到了网易杭研大厦")

>>>print ", ".join(seg_list)

他, 来到, 了, 网易, 杭研, 大厦

pullword在线分词服务__API服务_API服务_API Store

除了jieba补充两个,一个是哈工大的语言云,另一个是波森科技的NLP API。不过我没有对这三者进行横向测评过。

我用过jieba效果还阔以,用的不多。 不过听说stanfordnlp也支持中文分词,容我崇洋媚外一把 也许stanford更牛逼一点

张华平博士的东西什么都好,就是要定期更新用户授权

我用过腾讯文智的API觉得还行,简单,分词效果不错。可以试一试

词云的制作方法

以前用的庖丁解牛分词器 ,不过是潜入到lucene里面用的。对中文分词 挺不错的