Python multiprocessing.Pool默认采用“预分发”策略:任务提交即入共享队列,子进程空闲时主动拉取执行;无中心调度器,属简单高效的队列+工作窃取雏形,适合耗时均匀任务,但存在首任务阻塞问题。

Python的multiprocessing.Pool默认采用“预分发”(pre-distribution)策略:任务提交时即被放入内部任务队列,由空闲子进程主动拉取执行。这不是轮询或负载感知调度,而是一种简单高效的“队列+工作窃取”雏形。

默认分发机制:任务入队,进程自取

当你调用pool.apply_async()或pool.map()时,所有任务会先序列化并压入一个共享的multiprocessing.Queue(底层基于管道或共享内存)。子进程在完成当前任务后,立即尝试从该队列中get()下一个任务——没有中心调度器,也无实时负载汇报。

- 优点:低开销、高吞吐,适合任务耗时相对均匀的场景

- 缺点:若任务执行时间差异极大(如有的10ms、有的10s),短任务可能被“卡”在长任务之后,造成整体完成时间延长(head-of-line blocking)

- 注意:

chunksize参数仅影响map类方法——它把可迭代对象切分成块,每块作为一个子任务提交,减少IPC次数,但不改变“谁来执行哪一块”的逻辑

手动控制分发节奏:避免队列积压

如果任务生成速度远超处理速度(例如实时日志解析+慢速IO写入),默认队列可能无限增长,引发内存溢出。此时应限制未决任务数:

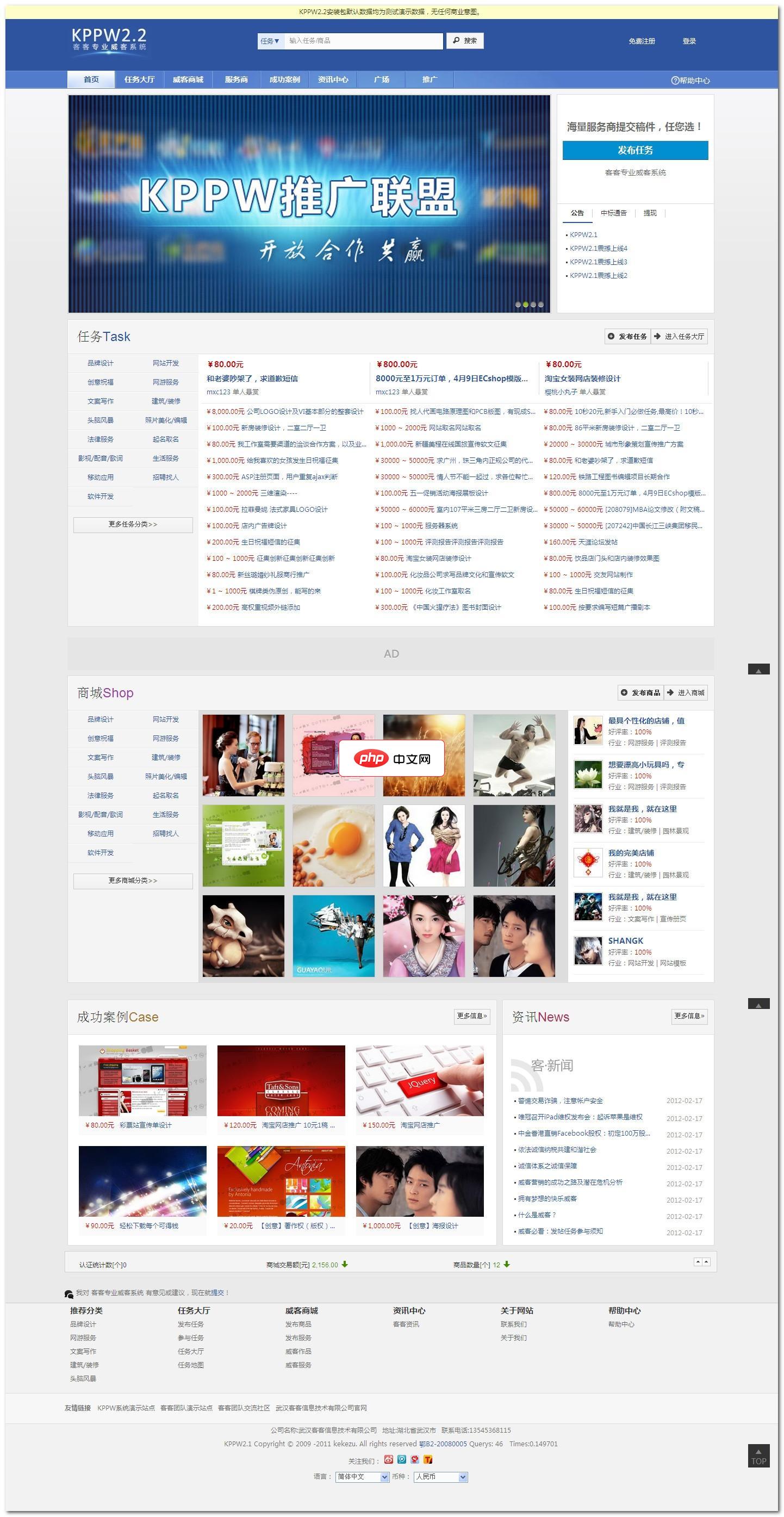

客客出品专业威客系统英文名称KPPW,也是keke produced professional witkey的缩写。KPPW是一款基于PHP+MYSQL技术构架的威客系统,积客客团队多年实践和对威客模式商业化运作的大量调查分析而精心策划研发,是您轻松搭建威客网站的首选利器。KPPW针对威客任务和商品交易模式进行了细致的分析,提供完善威客任务流程控制解决方案,并将逐步分享威客系统专业化应用作为我们的

- 使用

pool.apply_async(..., callback=...)配合计数器,在回调中触发下一批提交 - 改用

concurrent.futures.ProcessPoolExecutor,结合as_completed()+submit()实现流式提交 - 示例节制提交:保持最多20个待执行任务,每完成1个再submit 1个

绕过默认队列:自定义调度逻辑

当需要按优先级、资源标签或依赖关系调度时,可弃用Pool的内置队列,改用外部协调:

- 启动固定数量子进程,各自连接Redis或ZMQ作为任务源,实现优先级队列或广播/单播分发

- 用

multiprocessing.Manager创建dict或Queue做中央任务池,主进程按策略put(),子进程循环get_nowait()并处理 - 关键点:避免多个进程同时

get()引发竞争,需加锁或用线程安全结构

调试与观测:看清任务怎么跑的

默认情况下你无法知道哪个进程拿了哪个任务。可通过以下方式追踪:

- 在worker函数开头打印

os.getpid()和任务标识(如索引或ID) - 用

logging配置进程名(%(processName)s),配合文件handler分离日志 - 对关键路径加

time.time()戳,分析任务启动/结束时间分布,识别倾斜