HTML数据分析需先获取源码,再解析结构、提取清洗数据,最后用于SEO、竞品分析等;关键在掌握工具与业务结合,注意反爬与动态内容处理。

HTML数据是网页内容的核心载体,通过分析HTML可以提取结构化信息、理解页面布局、识别关键元素,并用于SEO优化、竞品监控、内容抓取等场景。要进行有效的网页分析,需掌握从获取到解析再到数据提取的完整流程。

1. 获取HTML数据

分析的第一步是获取目标网页的HTML源码。常见方式包括:

- 使用浏览器开发者工具:在浏览器中右键“检查”即可查看实时HTML结构,适合手动分析。

- 发送HTTP请求:通过Python的requests库或Node.js的axios获取页面源码。

- 处理动态加载内容:对于JavaScript渲染的页面,使用Selenium或Puppeteer模拟浏览器行为获取最终HTML。

2. 解析HTML结构

原始HTML是嵌套的标签结构,需通过解析器提取有用信息。

- 使用BeautifulSoup(Python):可方便地按标签、类名、ID等查找元素,支持CSS选择器和XPath类似语法。

- 使用Cheerio(Node.js):轻量级jQuery式HTML解析库,适合服务器端处理。

- 关注DOM树结构:理解父子、兄弟节点关系有助于精准定位目标内容。

3. 提取与清洗数据

从解析后的HTML中提取所需字段,并进行格式标准化。

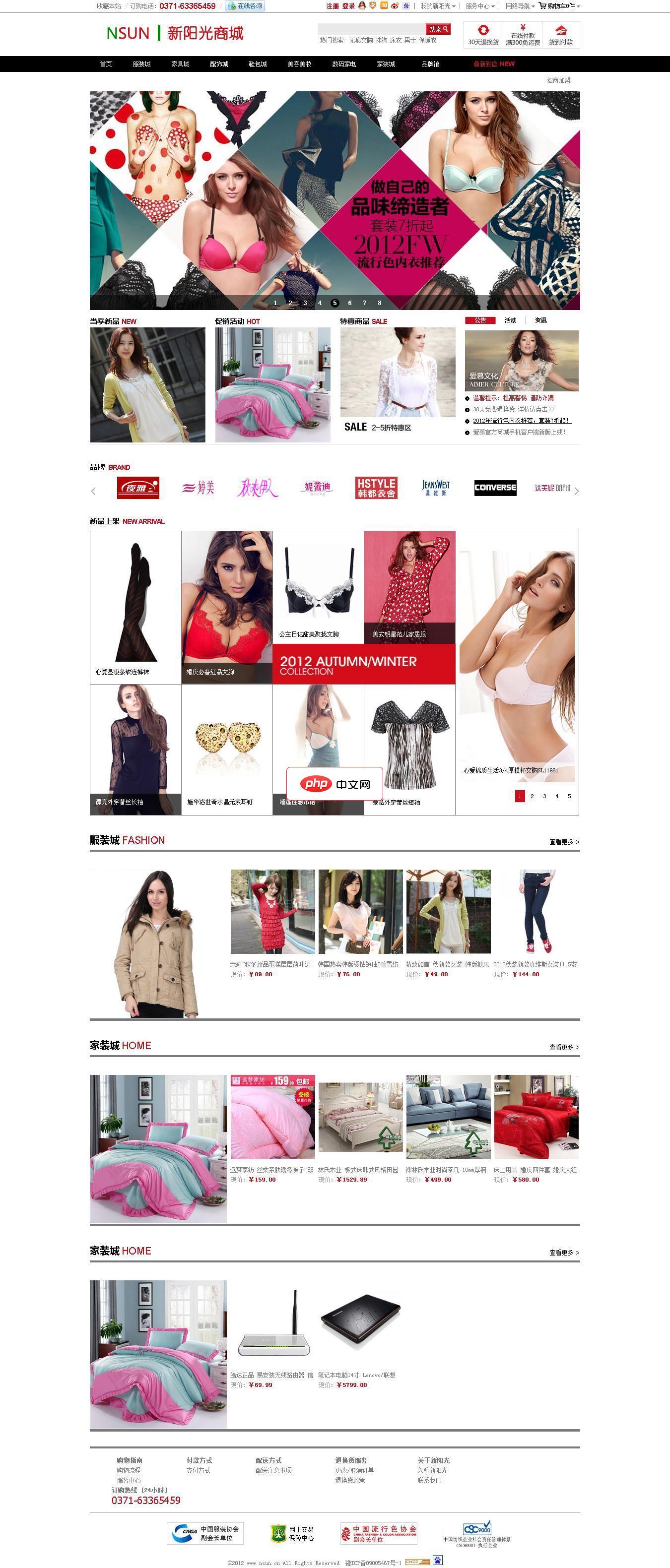

启科网络商城系统由启科网络技术开发团队完全自主开发,使用国内最流行高效的PHP程序语言,并用小巧的MySql作为数据库服务器,并且使用Smarty引擎来分离网站程序与前端设计代码,让建立的网站可以自由制作个性化的页面。 系统使用标签作为数据调用格式,网站前台开发人员只要简单学习系统标签功能和使用方法,将标签设置在制作的HTML模板中进行对网站数据、内容、信息等的调用,即可建设出美观、个性的网站。

立即学习“前端免费学习笔记(深入)”;

- 定位关键元素:如标题(h1-h6)、链接(a标签)、价格、评论等,常用class或id属性作为选择依据。

- 处理文本内容:去除多余空格、换行、HTML实体(如 ),统一编码格式。

- 提取属性值:如href、src、data-*自定义属性,可用于获取链接或隐藏数据。

- 处理多页或列表结构:循环遍历相似结构的元素块,批量提取数据。

4. 数据分析与应用

结构化数据可用于多种分析目的。

- 内容趋势分析:统计关键词频率、标题长度、图片数量等,评估内容质量。

- SEO审计:检查meta标签、h标签层级、alt属性是否规范。

- 竞品页面对比:抓取多个同类网站,比较其页面结构与内容策略。

- 构建训练数据集:为机器学习模型提供网页分类、信息抽取的样本。

基本上就这些。掌握HTML数据分析的关键在于熟悉网页结构、灵活运用解析工具,并结合实际业务目标设计提取逻辑。整个过程不复杂但容易忽略细节,比如反爬机制、编码问题或动态内容加载,需在实践中不断调试优化。