编辑|伊风

出品 | 51CTO技术栈(微信号:blog51cto)

谷歌终于出手了!我们将不再忍受大模型的“健忘症”。

TransformerFAM横空出世,放话要让大模型拥有无限记忆力!

话不多说,先来看看TransformerFAM的“疗效”:

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

图片

图片

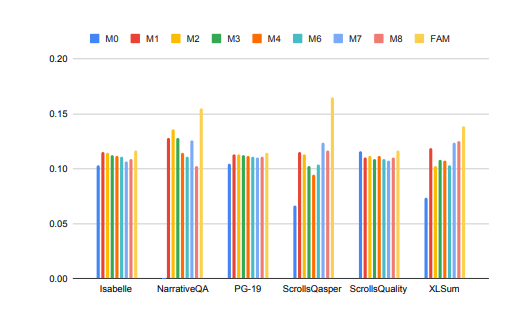

大模型在处理长上下文任务时的性能得到了显著提升!

在上图中,Isabelle、NarrativeQA等任务要求模型理解和处理大量上下文信息,并对特定问题给出准确的回答或摘要。在所有任务中,FAM配置的模型都优于所有其他BSWA配置,并且能够看到当超过某个点时,BSWA记忆段数量的增加已经无法继续提升其记忆能力。

看来,在卷长文本、长对话的路上,FAM这颗大模型的“忘不了”确实有点东西。

Google的研究人员介绍了FAM这种新颖的Transformer架构——Feedback Attention Memory。它利用反馈循环使网络能够关注自身的漂移表现,促进Transformer内部工作记忆的出现,并使其能够处理无限长的序列。

简单点说,这个策略有点像我们人工对抗大模型“失忆”的策略:每次和大模型对话前都再输入一次prompt。只不过FAM的做法更高阶一些,在模型处理新的数据块时,它会将之前处理过的信息(即FAM)作为一个动态更新的上下文,再次整合到当前的处理过程中。

这样就能很好地应对“爱忘事”的问题了。更妙的是,尽管引入了反馈机制来维持长期的工作记忆,但FAM的设计旨在保持与预训练模型的兼容性,不需要额外的权重。所以理论上说,大模型的强大记忆力,没有使其变得迟钝或者消耗更多的算力资源。

那么,这么妙的TransformerFAM是如何被探索出来的?相关技术又是啥?

一、从挑战中来,TransformerFAM为何能帮助大模型“记住更多”?

滑动窗口注意力(Sliding Window Attention, SWA)这个概念,对TransformerFAM的设计至关重要。

在传统的Transformer模型中,自注意力(Self-Attention)的复杂度随着序列长度的增加而呈二次方增长,这限制了模型处理长序列的能力。

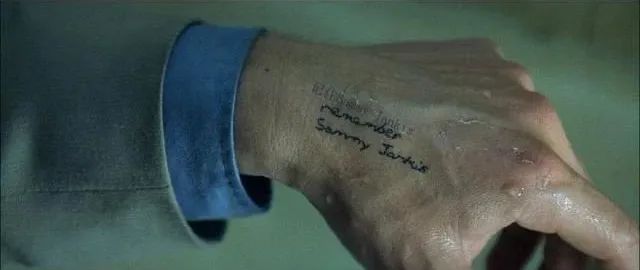

“在电影《记忆碎片》(2000 年)中,主角患有顺行性遗忘症,这意味着他无法记住过去 10 分钟发生的事情,但他的长期记忆是完好的,他不得不将重要信息纹在身上以记住它们。这与当前大型语言模型(LLMs)的状态类似,”论文中这样写道。

《记忆碎片》电影截图,图片源于网络

《记忆碎片》电影截图,图片源于网络

滑动窗口注意力(Sliding Window Attention),它是一种改进的注意力机制,用于处理长序列数据。它受到了计算机科学中滑动窗口技术(sliding window technique)的启发。在处理自然语言处理(NLP)任务时,SWA允许模型在每个时间步骤上只关注输入序列的一个固定大小的窗口,而不是整个序列。因此,SWA的优点在于它可以显著减少计算量。

图片

图片

但是SWA有局限性,因为它的注意力范围受限于窗口大小,这导致模型无法考虑到窗口之外的重要信息。

TransformerFAM通过添加反馈激活,将上下文表示重新输入到滑动窗口注意力的每个区块中,从而实现了集成注意力、区块级更新、信息压缩和全局上下文存储。

在TransformerFAM中,改进通过反馈循环实现。具体来说,模型在处理当前序列块时,不仅关注当前窗口内的元素,还会将之前处理过的上下文信息(即之前的“反馈激活”)作为额外的输入重新引入到注意力机制中。这样,即使模型的注意力窗口在序列上滑动,它也能够保持对之前信息的记忆和理解。

于是,经过这番改进,TransformerFAM就给了LLMs能够处理无限长度序列的潜力!

二、有了工作记忆的大模型,继续向AGI迈进

TransformerFAM在研究中展现出了积极的前景,这将毫无疑问地提升AI在理解和生成长文本任务中的性能,例如处理文档摘要、故事生成、问答等工作。

图片

图片

同时,无论是智能助手还是情感陪伴,一个有无限记忆力的AI听起来都更有吸引力。

有趣的是,TransformerFAM的设计灵感来源于生物学中的记忆机制,这一点与AGI追求的自然智能模拟不谋而合。这篇论文正是一个来自神经科学的概念——基于注意力的工作记忆——整合到深度学习领域的尝试。

TransformerFAM通过反馈循环为大模型引入了工作记忆,使得模型不仅能够记住短期的信息,还能够在长期序列中维持对关键信息的记忆。

通过大胆的想象,研究人员在现实世界与抽象概念间假设起桥梁。随着TransformerFAM这样的创新成果继续涌现出来,技术的瓶颈会一次次被突破,一个更加智能、互联的未来正向我们徐徐地展开画卷。

想了解更多AIGC的内容,请访问:

51CTO AI.x社区

https://www.51cto.com/aigc/