借助Google AI工具为开源项目提供高质量维护建议需系统化策略:一、用Vertex AI Codey定制提示词;二、用Gemini分析GitHub Actions日志识别异常模式;三、基于BigQuery公共数据集提炼高活跃项目特征;四、用Colab+LangChain协同调用多模型分阶段分析。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

如果您希望借助 Google AI 工具为开源项目提供维护建议,但缺乏系统化提示策略或上下文构建方法,则可能无法获得准确、可落地的反馈。以下是生成高质量维护建议的多种实现路径:

一、使用 Vertex AI 的 Codey 模型定制提示词

Codey 是 Google 基于 PaLM 2 构建的代码专用模型,支持多语言理解与上下文感知生成。通过构造包含项目结构、近期 issue 分布和 commit 频率的提示词,可引导其输出针对性建议。

1、在 Vertex AI Studio 中选择 codey-32b 或 codey-6b 模型实例。

2、输入提示词模板:“你是一个资深开源维护者。请基于以下信息:项目语言为 Python;最近 7 天有 12 个 open issue,其中 5 个标记为 ‘bug’;主分支过去 30 天平均每周合并 4 个 PR;当前未配置 Dependabot。请列出三项最应优先执行的维护动作,并说明每项动作对 issue 关闭率或贡献者参与度的影响。”

3、设置 temperature 为 0.3,max output tokens 为 512,提交请求。

二、将 GitHub Actions 日志导入 Gemini 进行异常模式识别

Gemini 支持多模态输入,可解析结构化日志文本并识别重复失败模式。该方法适用于 CI/CD 流水线稳定性优化场景。

1、在 GitHub Actions 工作流中添加步骤,将最近 5 次失败的 workflow-run logs 导出为纯文本文件。

2、调用 Gemini API,以 multipart 方式上传日志文本,并发送指令:“逐行扫描以下日志,提取所有唯一出现的错误关键词(如 ‘timeout’、‘permission denied’、‘module not found’),统计各关键词在不同作业中的出现频次,并指出最可能导致整体失败率上升的两个根本原因。”

3、解析返回的 JSON 响应,提取 error_keywords 字段与 root_cause 字段内容。

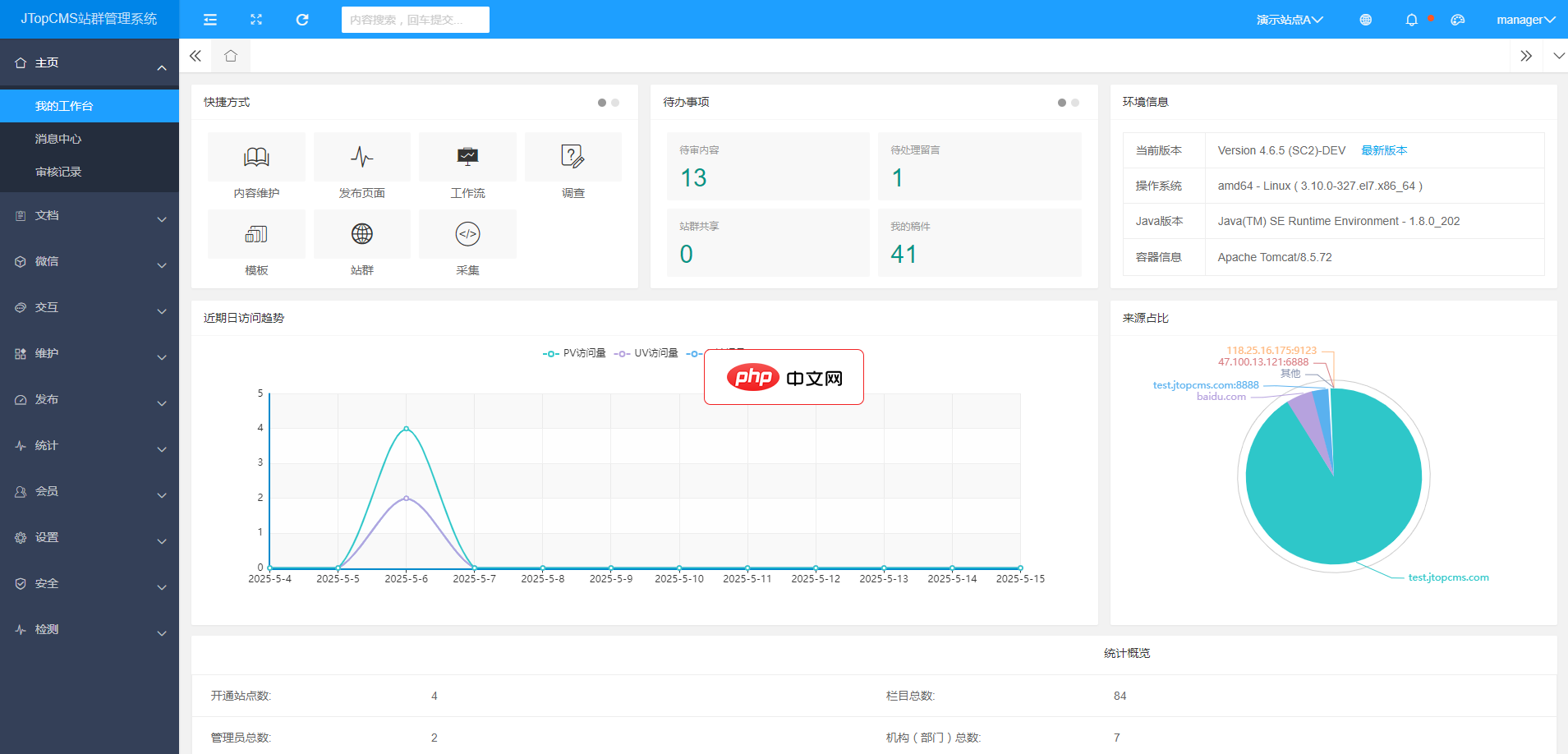

JTopCMS基于JavaEE自主研发,是用于管理站群内容的国产开源软件(CMS),能高效便捷地进行内容采编,审核,模板制作,用户交互以及文件等资源的维护。安全,稳定,易扩展,支持国产中间件及数据库,适合建设政府,教育以及企事业单位的站群系统。 系统特色 1. 基于 JAVA 标准自主研发,支持主流国产信创环境,国产数据库以及国产中间件。安全,稳定,经过多次政务与企事业单位项目长期检验,顺利通过

三、基于 BigQuery 公共数据集训练轻量级维护倾向分类器

Google Cloud 提供的 github_repos 数据集包含数百万条开源仓库元数据。可通过 SQL 查询提取高活跃度项目特征,作为维护建议生成的先验依据。

1、在 BigQuery 控制台执行查询:“SELECT repo.name, COUNT(DISTINCT actor.login) as contributor_count, COUNT(*) as pr_count FROM `bigquery-public-data.github_repos.sample_commits` c JOIN `bigquery-public-data.github_repos.sample_files` f ON c.repo_name = f.repo_name WHERE c.committer.date >= DATE_SUB(CURRENT_DATE(), INTERVAL 90 DAY) GROUP BY repo.name HAVING contributor_count > 15 AND pr_count > 80 ORDER BY pr_count DESC LIMIT 10”

2、导出结果至 CSV,识别共性特征(如默认分支命名统一为 main、.github/workflows 目录存在且含至少 2 个 YAML 文件)。

3、将上述特征映射为检查项清单,用于比对目标项目当前配置是否符合高维护效率项目的典型实践。

四、利用 Google Colab + LangChain 调用多个 Google AI 模型协同分析

LangChain 支持串联多个 LLM 调用,适合需分阶段处理的任务,例如先摘要 issue 描述再归类再排序优先级。

1、在 Colab 中安装 langchain-google-genai 和 google-generativeai 库。

2、初始化三个 LLM 链:issue_summarizer(使用 gemini-pro)、category_router(使用 codey-6b)、priority_ranker(使用 text-bison)

3、构建链式流程:输入原始 issue 列表 → summarizer 输出 30 字摘要 → router 标注 “documentation”、“test coverage”、“dependency update” 等类别 → ranker 对同类 issue 按 reporter 活跃度与复现步骤完整性打分并排序。