Scrapy建模通过Item定义数据结构,1. 在items.py中创建继承scrapy.Item的类并用Field()声明字段;2. Spider中实例化Item填充数据;3. 可使用ItemLoader简化提取流程,支持输入输出处理器;4. 通过Pipeline实现数据存储与处理,需在settings.py中启用。

在使用 Python Scrapy 进行爬虫开发时,建模主要是通过 Item 来完成的。Scrapy 的 Item 类似于数据模型,用来定义你要抓取的数据结构,类似于 Django 中的 Model 或数据库表结构。

1. 定义 Item 模型

在 Scrapy 项目中,Item 是在 items.py 文件中定义的。你可以创建一个类继承 scrapy.Item,然后用 scrapy.Field() 来声明字段。

例如,你想爬取书籍信息:

import scrapyclass BookItem(scrapy.Item): title = scrapy.Field() price = scrapy.Field() author = scrapy.Field() publish_date = scrapy.Field() rating = scrapy.Field()

2. 在 Spider 中使用 Item

在编写爬虫(Spider)时,导入并实例化你定义的 Item,然后填充数据。

立即学习“Python免费学习笔记(深入)”;

import scrapy from myproject.items import BookItemclass BookSpider(scrapy.Spider): name = 'book_spider' start_urls = ['https://www.php.cn/link/d0a446d119cee636ddcafab757831a9f']

def parse(self, response): item = BookItem() item['title'] = response.css('h1.title::text').get() item['price'] = response.css('span.price::text').get() item['author'] = response.css('span.author::text').get() item['publish_date'] = response.css('span.date::attr(content)').get() item['rating'] = response.css('div.rating::text').re_first(r'(\d+\.\d)') yield item

3. 使用 Item Loader 简化数据提取(可选但推荐)

当字段提取逻辑复杂时,可以使用 ItemLoader 来简化和规范化处理流程。

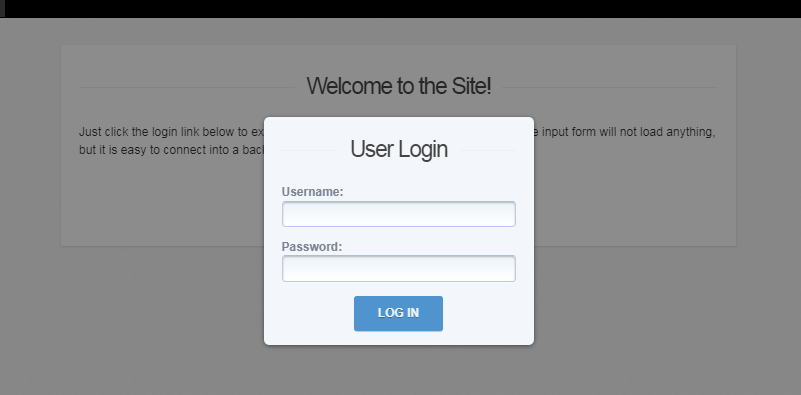

何利用jQuery插件leanModal建立一个常规模态窗口。如果你有MIT general license,那么这个插件是完全开源和免费的,我很喜欢这个插件,用起来相当方便,还能自行添加CSS,达到自定义的效果。

先在 items.py 中定义 Loader:

from scrapy.loader import ItemLoader from scrapy.loader.processors import TakeFirst, MapComposeclass BookItem(scrapy.Item): title = scrapy.Field( input_processor=MapCompose(str.strip), output_processor=TakeFirst() ) price = scrapy.Field() author = scrapy.Field() publish_date = scrapy.Field() rating = scrapy.Field()

可以在 spider 中使用

from scrapy.loader import ItemLoader

def parse(self, response): loader = ItemLoader(item=BookItem(), response=response) loader.add_css('title', 'h1.title::text') loader.add_css('price', 'span.price::text') loader.add_value('url', response.url) yield loader.load_item()

4. 数据输出与管道处理

定义好 Item 后,可以通过 Pipeline 将数据保存到 JSON、数据库等。确保在 settings.py 中启用 Pipeline:

ITEM_PIPELINES = {

'myproject.pipelines.CleanDataPipeline': 300,

'myproject.pipelines.SaveToDatabasePipeline': 400,

}

基本上就这些。Scrapy 建模核心是 Item + Field + Pipeline 配合,结构清晰,易于维护和扩展。不复杂但容易忽略细节,比如字段预处理和异常处理,建议结合实际项目逐步优化。