Golang处理二进制文件的核心是将文件视为字节流,利用os包进行文件操作,encoding/binary包实现数据解析。通过binary.Read和binary.Write可按指定字节序(BigEndian或LittleEndian)读写基本数据类型,确保跨平台兼容性。对于大型文件,推荐使用分块读取结合bufio.NewReader以降低内存占用;复杂格式则可通过定义结构体映射文件布局,配合循环、变长字段处理和嵌套解析实现高效读取。此外,标准库如image/jpeg等已支持常见二进制格式,优先使用可避免重复造轮子。

Golang处理二进制文件,核心思路其实就是把文件看作一串字节流,然后根据我们预设的格式,把这些字节“切片”并“解释”成Go语言中的数据类型。最直接的方法,莫过于打开文件,然后用

Read方法将字节读入预先准备好的字节切片中,如果需要更结构化的处理,

encoding/binary包会是你的好帮手。

解决方案

在Golang中读取二进制文件数据,通常会涉及

os包的文件操作和

encoding/binary包的数据解析。下面我们通过一个具体的例子来展示如何读取一个简单的二进制文件,这个文件可能包含一些整数和浮点数。

假设我们有一个名为

data.bin的二进制文件,里面依次存储了一个

int32、一个

float64和一个

uint16。

package main

import (

"encoding/binary"

"fmt"

"io"

"os"

)

func main() {

// 创建一个示例二进制文件,实际应用中你可能直接读取现有文件

createBinaryFile("data.bin")

file, err := os.Open("data.bin")

if err != nil {

fmt.Println("Error opening file:", err)

return

}

defer file.Close() // 确保文件在函数结束时关闭

var (

intValue int32

floatValue float64

ushortValue uint16

)

// 使用 binary.Read 读取数据

// 默认使用 BigEndian,如果你的文件是 LittleEndian,需要明确指定

// 这里我们假设文件是 LittleEndian 写入的

err = binary.Read(file, binary.LittleEndian, &intValue)

if err != nil {

fmt.Println("Error reading int32:", err)

return

}

err = binary.Read(file, binary.LittleEndian, &floatValue)

if err != nil {

fmt.Println("Error reading float64:", err)

return

}

err = binary.Read(file, binary.LittleEndian, &ushortValue)

if err != nil {

fmt.Println("Error reading uint16:", err)

return

}

fmt.Printf("从二进制文件读取的数据:\n")

fmt.Printf("Int32: %d\n", intValue)

fmt.Printf("Float64: %f\n", floatValue)

fmt.Printf("Uint16: %d\n", ushortValue)

// 也可以直接读取字节切片,然后手动解析

// 比如,我们想读取接下来的4个字节作为一个新的int32(如果文件还有内容的话)

// 这里为了演示,我们假设文件已经读完,仅作概念说明

// data := make([]byte, 4)

// _, err = file.Read(data)

// if err != nil && err != io.EOF {

// fmt.Println("Error reading bytes:", err)

// return

// }

// if len(data) == 4 {

// // 手动从字节切片转换为int32,需要考虑字节序

// manualInt := int32(binary.LittleEndian.Uint32(data))

// fmt.Printf("手动解析的Int32: %d\n", manualInt)

// }

}

// 辅助函数:创建一个示例二进制文件

func createBinaryFile(filename string) {

file, err := os.Create(filename)

if err != nil {

fmt.Println("Error creating file:", err)

return

}

defer file.Close()

var (

intValue int32 = 123456789

floatValue float64 = 3.1415926535

ushortValue uint16 = 65530

)

// 以 LittleEndian 写入数据

binary.Write(file, binary.LittleEndian, intValue)

binary.Write(file, binary.LittleEndian, floatValue)

binary.Write(file, binary.LittleEndian, ushortValue)

fmt.Printf("已创建示例二进制文件 '%s',并写入数据。\n", filename)

}这段代码展示了如何使用

os.Open打开文件,以及

encoding/binary包中的

binary.Read函数来按指定字节序(这里是

LittleEndian)读取不同类型的数据。

binary.Read非常方便,它会自动处理字节到Go数据类型的转换。

立即学习“go语言免费学习笔记(深入)”;

Golang处理二进制数据时如何有效管理字节序(Endianness)?

字节序,也就是我们常说的Endianness,在二进制数据处理中是个绕不开的话题。简单来说,它决定了多字节数据(比如一个32位的整数)在内存或文件中存储时,字节的排列顺序。有两种主要的字节序:大端序(Big-Endian)和小端序(Little-Endian)。大端序是高位字节存储在低地址,小端序是低位字节存储在低地址。想象一下,一个数字12345678,在大端序里可能是

0x01 0x23 0x45 0x67,而在小端序里就成了

0x67 0x45 0x23 0x01。

在Go语言中,

encoding/binary包对此提供了非常直接的支持。当你使用

binary.Read或

binary.Write时,它要求你明确指定字节序,例如

binary.LittleEndian或

binary.BigEndian。这其实是个非常好的设计,避免了隐式转换可能带来的陷阱。我个人觉得,这种显式指定的方式,虽然初看可能觉得多了一步,但它强制你思考数据的来源和目标,确保了跨平台或系统间数据交换的准确性。

如果你在处理一个外部文件或网络协议,第一步通常是确认其使用的字节序。这通常会在协议规范或文件格式说明中明确指出。一旦确认,就始终使用对应的

binary.LittleEndian或

binary.BigEndian来读写数据。

有时候,你可能需要更底层的操作,比如从一个

[]byte切片中手动解析数据。

binary包也提供了

LittleEndian.Uint16(),

BigEndian.Uint32()等方法,可以直接从字节切片中提取指定字节序的无符号整数。这在处理一些复杂、非标准的数据结构时特别有用,你可以先读取一个字节块,再根据需要从中解析出各个字段。这种灵活性使得Go在处理各种二进制数据时都显得游刃有余。

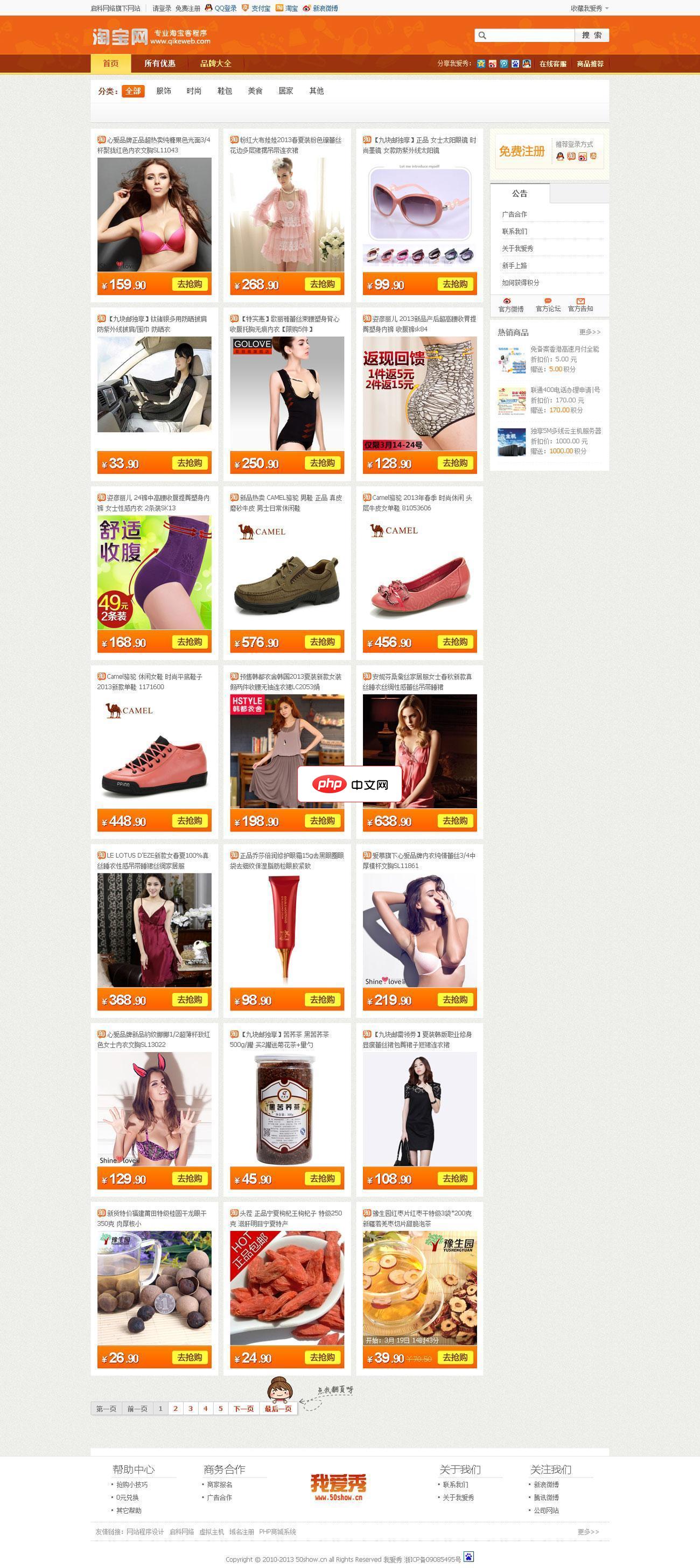

1、请上传下载到的淘宝客系统安装包并上传到空间根目录中进行解压,解压后将网站文件移动到根目录的位置,然后访问 /install 进行安装。您也可以在本地解压,并以二进制方式将程序上传至您的网站空间。 2、同意启科网络电子商务系统安装协议进入下一步。 3、如果系统检测环境通过,则会提示输入您的数据库服务器地址(一般为本机,即127.0.0.1或者localhost)、数据库账号、数据库密码、数据库名

读取大型二进制文件时,Golang有哪些内存和性能优化策略?

当文件大小不再是几十KB,而是MB甚至GB级别时,直接将整个文件读入内存显然不是一个明智的选择,那会迅速耗尽系统资源。这时候,我们需要一些更精细的策略。

一个最常用的方法是分块读取。你可以定义一个固定大小的缓冲区(例如4KB、8KB或更大),然后循环调用

file.Read()方法,每次读取一部分数据到缓冲区,处理完后再读取下一部分。这就像吃自助餐,你不会一次性把所有菜都端到桌上,而是每次拿一盘。

io.Reader接口的本质就是支持这种流式读取。配合

bufio.NewReader,可以进一步提升性能,因为它会在内部维护一个缓冲区,减少底层系统调用次数。

// 示例:分块读取大文件

func readLargeFileInChunks(filename string, chunkSize int) error {

file, err := os.Open(filename)

if err != nil {

return fmt.Errorf("failed to open file: %w", err)

}

defer file.Close()

reader := bufio.NewReader(file)

buffer := make([]byte, chunkSize)

for {

n, err := reader.Read(buffer)

if n > 0 {

// 处理 buffer[:n] 中的数据

// fmt.Printf("读取了 %d 字节\n", n)

// 这里可以对读取到的数据进行解析、处理、写入等操作

}

if err == io.EOF {

break // 文件读取完毕

}

if err != nil {

return fmt.Errorf("error reading file: %w", err)

}

}

return nil

}另一个值得考虑的优化是内存映射文件(Memory-Mapped Files),在Go中可以通过

syscall.Mmap实现。内存映射文件将文件内容直接映射到进程的虚拟内存空间,操作系统会负责文件的读写和缓存,这对于随机访问文件中的数据特别高效,因为你可以像访问内存切片一样访问文件内容,而不需要显式地调用

Read或

Write。但需要注意的是,

syscall包是平台相关的,且使用不当可能导致资源泄露或程序崩溃,所以通常在对性能要求极高且熟悉操作系统底层机制的场景下才考虑使用。对我来说,如果不是有非常明确的性能瓶颈,我更倾向于使用

bufio进行分块读取,因为它更安全、更跨平台。

最后,如果你在处理的数据是结构化的,比如日志文件或数据库文件,考虑使用零拷贝(Zero-Copy)技术。虽然Go标准库没有直接提供零拷贝的API,但一些第三方库可能会通过

sendfile或

splice等系统调用来优化数据传输。但对于普通的二进制文件解析,分块读取和

bufio通常已经足够应对大部分性能挑战了。

除了基本读取,Golang还有哪些高级方法可以解析复杂的二进制文件格式?

仅仅把字节读出来,或者用

binary.Read解析几个基本类型,对于复杂的二进制文件格式来说是远远不够的。很多文件格式,比如图片(JPEG, PNG)、音频(WAV)、视频(MP4)或者各种自定义的数据存储格式,都有其独特的头部(Header)、数据块(Chunks)和尾部(Footer)结构,甚至可能包含压缩数据、加密数据或变长字段。

处理这类复杂格式,核心思想是将二进制结构映射到Go的结构体(Struct)。你可以为文件的每个逻辑部分定义一个Go结构体,并使用

binary.Read配合这些结构体来一次性读取一个数据块。

// 假设一个自定义文件头部结构

type MyFileHeader struct {

MagicNumber [4]byte // 比如 "MYFH"

Version uint16

DataSize uint32

Timestamp uint64

_ [8]byte // 填充字节,对齐或保留

}

// 假设一个数据块结构

type DataBlock struct {

ID uint8

Length uint16

Data []byte // 这里的长度需要动态处理

}

// 在实际读取时

func parseComplexFile(filename string) error {

file, err := os.Open(filename)

if err != nil {

return err

}

defer file.Close()

var header MyFileHeader

// 注意字节序,假设是LittleEndian

if err := binary.Read(file, binary.LittleEndian, &header); err != nil {

return fmt.Errorf("failed to read header: %w", err)

}

fmt.Printf("Magic: %s, Version: %d, DataSize: %d\n", string(header.MagicNumber[:]), header.Version, header.DataSize)

// 接下来可能需要循环读取多个数据块

for i := 0; i < int(header.DataSize); i++ { // 假设DataSize代表数据块数量

var blockID uint8

var blockLength uint16

if err := binary.Read(file, binary.LittleEndian, &blockID); err != nil {

if err == io.EOF {

break

}

return fmt.Errorf("failed to read block ID: %w", err)

}

if err := binary.Read(file, binary.LittleEndian, &blockLength); err != nil {

return fmt.Errorf("failed to read block length: %w", err)

}

blockData := make([]byte, blockLength)

if _, err := io.ReadFull(file, blockData); err != nil {

if err == io.EOF {

break

}

return fmt.Errorf("failed to read block data: %w", err)

}

fmt.Printf("Block ID: %d, Length: %d, Data: %x\n", blockID, blockLength, blockData)

// 在这里进一步解析 blockData,可能根据 blockID 有不同的解析逻辑

}

return nil

}这里需要注意几点:

-

字段对齐和填充:二进制文件格式通常有严格的字段对齐要求。Go的结构体字段默认是按Go的内存对齐规则排列的,这可能与二进制文件中的对齐方式不一致。如果出现这种情况,你可能需要在结构体中加入

_ [N]byte

这样的匿名字段进行填充,或者手动分字节读取。 -

变长字段:如果数据块的长度是可变的,比如一个字符串,通常文件会先存储一个表示长度的字段,然后才是实际的数据。

binary.Read

无法直接处理变长切片,你需要先读取长度,然后用make([]byte, length)

创建一个切片,再用io.ReadFull

或file.Read

读取数据。 - 嵌套结构和递归解析:复杂格式可能包含嵌套的数据结构。你可以定义多个结构体,并在解析过程中递归调用解析函数。

-

错误处理和容错:二进制文件的解析往往需要细致的错误处理,比如

io.EOF

的处理、校验和的检查等。

对于一些非常标准且复杂的格式,比如图像或音频,Go标准库(如

image/jpeg、

image/png)或成熟的第三方库已经提供了现成的解析器。在可能的情况下,优先使用这些库,它们通常已经处理了大部分细节和边缘情况,省去了我们从头造轮子的麻烦。毕竟,解析一个完整的JPEG文件可不是闹着玩的。