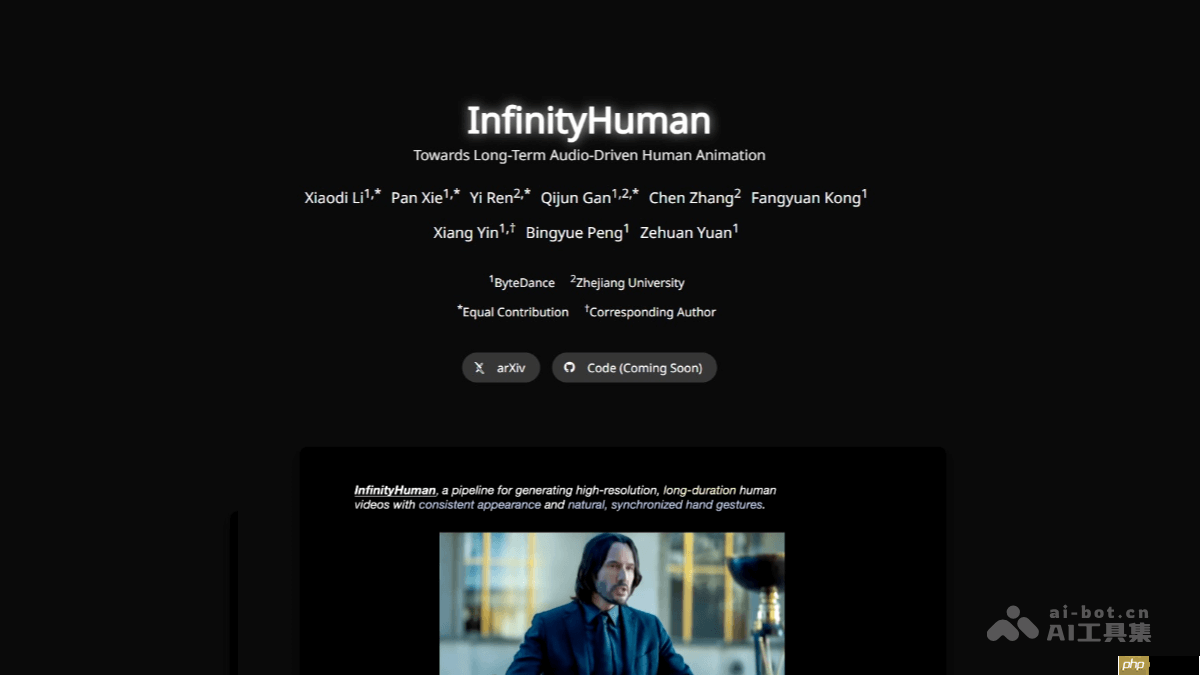

infinityhuman 是由字节跳动与浙江大学联合研发的商用级音频驱动人物视频生成模型,标志着 ai 数字人迈向实用化的重要一步。该模型采用 coarse-to-fine(由粗到精) 的生成框架,首先生成低分辨率的动作序列作为基础,再通过姿态引导细化器逐步升维至高分辨率长时视频。其创新性地引入手部专属奖励机制,显著提升了手部动作的自然度与语音同步性,有效缓解了身份漂移、画面抖动及手势僵硬等长期存在的问题。在 emtd 和 hdtf 等权威数据集上的实验表明,infinityhuman 在生成质量与稳定性方面均达到领先水平,为虚拟主播、在线教育、智能客服等应用场景提供了强有力的技术支持。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

InfinityHuman的核心功能

InfinityHuman的核心功能

- 长时序稳定生成:支持生成高分辨率、长时间连续的人物视频,保持动作流畅和画面稳定。

- 精准手部建模:通过专门设计的手部奖励机制,实现手势动作自然、准确,并与语音节奏高度同步。

- 强身份一致性:结合姿态序列作为中间表示与首帧图像作为视觉锚点,有效抑制长时间生成中的身份偏移。

- 高精度口型匹配:唇形变化与输入音频精准对齐,增强人物表达的真实感。

- 多风格适配能力:可适配不同外貌、服饰和风格的角色形象,满足多样化应用需求。

InfinityHuman的技术架构

- 低分辨率动作预生成:模型首先根据音频信号生成低分辨率的姿态序列,作为全局动作的“草图”,确保嘴型、头部运动和肢体节奏初步对齐。

-

姿态引导细化器(Pose-Guided Refiner):在此基础上,细化器以低分辨率姿态为指导,逐阶段恢复细节,生成高清视频。

- 稳定中间表示:姿态序列作为时间维度上的稳定桥梁,防止长期生成中出现退化。

- 首帧锚定机制:始终以输入的参考图像为首帧锚点,持续校正身份特征,避免累积误差。

- 手部动作优化:利用高质量手部动作数据集进行强化学习训练,引入手部奖励函数,提升手势自然度与语义相关性。

- 多模态条件融合机制:整合音频、参考图像、文本提示等多种输入模态,实现语义一致、情感匹配的多维协同生成。

InfinityHuman的官方资源

- 项目主页:https://www.php.cn/link/a1dd9267e737ca837e80cb0f1bb7118d

- 论文链接:https://www.php.cn/link/476650d630a12751578bf6f9a84f359e

InfinityHuman的典型应用

- 虚拟主播:实现24小时不间断、动作自然的直播播报,广泛应用于新闻、电商带货等场景。

- AI 教学助手:在网课中模拟真人教师的手势与表情,提升知识传递的生动性与吸引力。

- 智能客服系统:打造具备非语言反馈能力的数字客服,提升交互亲和力与服务体验。

- 影视动画生产:加速角色动画制作流程,降低人力成本,适用于动画剧集、广告短片等制作。

- 虚拟社交与元宇宙:为 VR/AR 中的虚拟化身注入真实表情与动作,推动沉浸式社交发展。